在Spark中,cogroup函数对不同的数据集执行,比方说,(K,V)和(K,W)并返回(K,(Iterable,Iterable))元组的数据集。此操作也称为groupWith。

cogroup函数示例

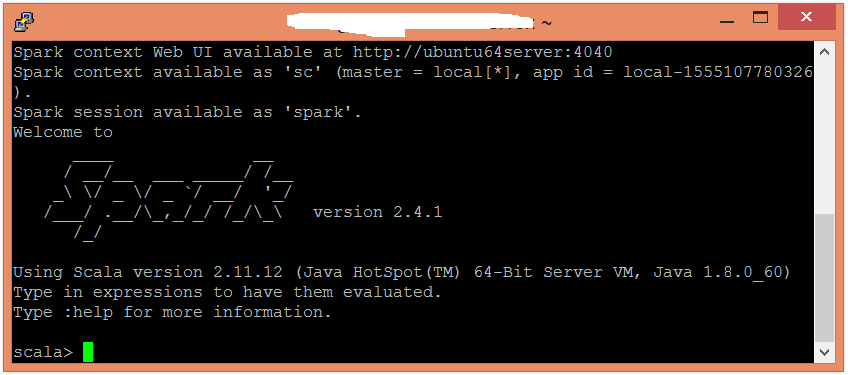

在这个例子中,将执行groupWith操作。要在Scala模式下打开Spark,请按照以下命令操作。

$ spark-shell

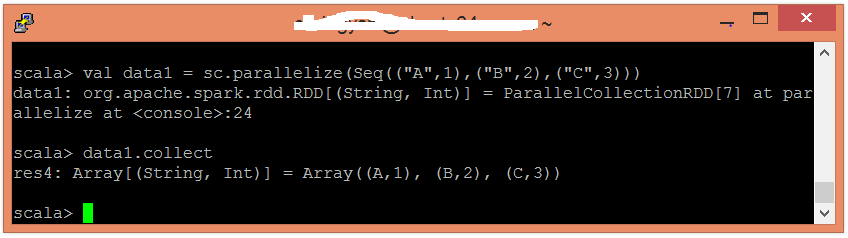

使用并行化集合创建RDD。

scala> val data1 = sc.parallelize(Seq(("A",1),("B",2),("C",3)))

现在,可以使用以下命令读取生成的结果。

scala> data1.collect

使用并行化集合创建另一个RDD。

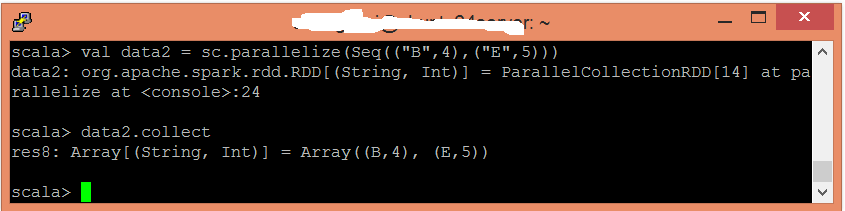

scala> val data2 = sc.parallelize(Seq(("B",4),("E",5)))

现在,可以使用以下命令读取生成的结果。

scala> data2.collect

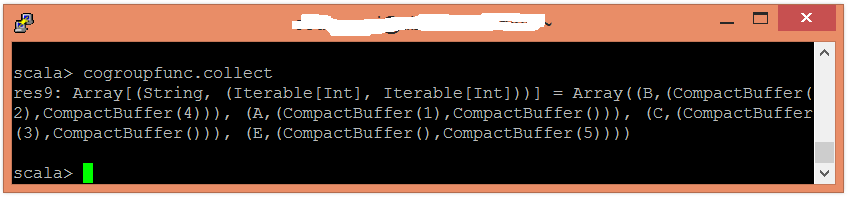

应用cogroup()函数对值进行分组。

scala> val cogroupfunc = data1.cogroup(data2)

现在,可以使用以下命令读取生成的结果。

scala> cogroupfunc.collect